Recentemente, conversei com um pesquisador de inteligência artificial (IA) chamado Rafael Rafailov, da Universidade de Stanford. Lá pelas tantas, falando sobre o caminho que a inteligência artificial deverá percorrer num futuro próximo, ele disse uma frase que cada vez mais tem se provado verdade: “LLMs 1Large language models, ou, grandes modelos de linguagem. são o passado, multimodalidade é o presente, e agentes são o futuro.”

Essencialmente, segundo Rafailov, a tecnologia envolvida no treinamento e na disponibilização de um LLM “básico” já é algo relativamente domado pelo mercado de tecnologia. A evolução disso é a multimodalidade, ou seja, a capacidade de esses modelos de também lidarem com imagens, áudios e outros tipos de arquivos além de texto puro.

Já o futuro, de acordo com ele, está nos agentes, que são basicamente IAs que identificam e decidem sozinhas a melhor forma de cumprir um pedido feito pelo usuário — e fazem isso por conta própria, sem a necessidade da validação ou do acompanhamento do processo por parte do usuário 2Arriscado? Sem dúvida. Empolgante? Também!. Na prática, é o Jarvis do Homem de Ferro ou, para um exemplo mais próximo das necessidades do dia a dia, boa parte dos benefícios prometidos pela empresa rabbit, com o recém-anunciado r1.

Na última semana, pensei bastante na frase de Rafailov no contexto de um novo estudo publicado pela Apple em conjunto com a Cornell University, chamado “Ferret-UI: Grounded Mobile UI Understanding With Multimodal LLMs”, ou “Ferret-UI: Ancoragem para Compreensão de Interfaces Móveis com LLMs Multimodais”, e explicado nesse nosso post.

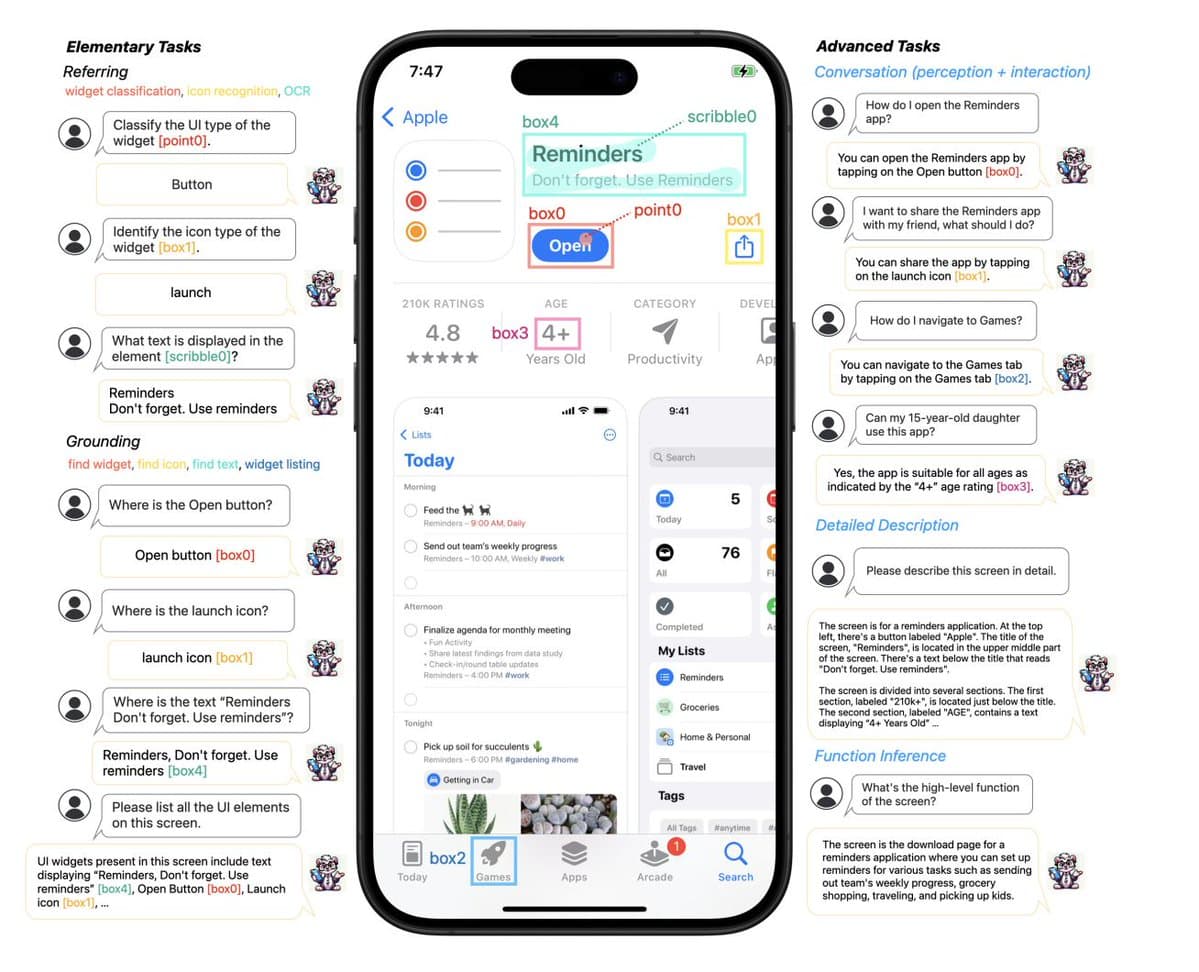

Essencialmente, o Ferret-UI é um modelo que reconhece interfaces, e que foi desenvolvido a partir do Ferret: um LLM multimodal (MLLM) de código aberto, que a Apple disponibilizou para pesquisadores em outubro do ano passado, e que acaba de ganhar uma segunda versão.

Com um desempenho mais preciso de compreensão de imagens do que o GPT-4 Vision da OpenAI, o Ferret permite que o usuário aponte, enquadre ou circule regiões de uma imagem, e interaja com um LLM para conversar, consultar ou tirar dúvidas a respeito da parte sinalizada.

Já o Ferret-UI é basicamente uma versão do Ferret treinada especificamente para compreender interfaces de celular, com o benefício de, por meio de um LLM, abrir caminho para a interação a respeito do que está na tela.

E é aqui que a coisa começa a ficar interessante.

A promessa da Siri, enfim, pode ser cumprida

Eu já disse isso antes, mas vale repetir: se você nunca assistiu à apresentação original da Siri, vale vê-la com o contexto de 2024. Digo isso porque é bastante irônico ver que todos os problemas apontados por Phil Schiller nos primeiros segundos do segmento, são justamente as coisas que a Siri geralmente não consegue fazer direito até hoje.

Mais do que isso, frases como “O seu dispositivo precisa entender o que você quis dizer, e fazer o que você pediu” e “A assistente inteligente que cumpre as solicitações que você faz para ela”, ditas logo no início da apresentação de 2011, são bons exemplos do que muitos de nós aguardamos ansiosamente para ver na WWDC24. E o que a soma dessas duas frases significa, senão a definição de um agente de IA embutido no iPhone?

No contexto do Ferret-UI, não precisamos ir muito longe para entender o que isso pode oferecer nas mãos virtuais da Siri. No próprio estudo, a Apple elenca possibilidades que incluem os campos de acessibilidade (“Qual é o texto que está escrito nesta área da interface?”), interação guiada (“Quero compartilhar o app de Lembretes com um amigo. O que devo fazer?”) e até mesmo FAQ (“Minha filha de 15 anos pode usar este aplicativo?”), todas oriundas de informações que não fizeram parte do treinamento do modelo, mas que estão na tela.

Agora… apesar de citar brevemente o conceito de agentes logo no primeiro parágrafo do estudo do Ferret-UI, a Apple não dedica muito tempo a isso no resto do texto. Ela diz apenas que:

Avanços recentes em MLLMs têm sido notáveis, no entanto, esses MLLMs de domínio geral frequentemente deixam a desejar em sua habilidade de compreender e interagir com as interfaces. Neste estudo, nós apresentamos o Ferret-UI, um novo MLLM desenvolvido na medida certa para compreender as interfaces de dispositivos móveis, equipado com capacidades de referenciamento, fundamentação e raciocínio.

Ainda assim, algumas palavras-chave aqui são bem interessantes, sendo elas interagir e raciocínio 3Muitas pessoas criticam o uso de termos que antropomorfizam a IA dessa forma, mas reasoning/raciocínio é um termo amplamente compreendido e aplicado em discussões técnicas e acadêmicas no campo da IA.. Elas indicam que, uma vez dominada a tecnologia desse MLLM, sua evolução natural será permitir que a IA interaja diretamente com as interfaces e, por meio desse raciocínio, executem ações por conta própria.

De fato, MLLMs são o presente, e agentes são o futuro.

Siri Intents 2.0

Há alguns anos, a Apple anunciou os Siri Intents (e posteriormente os App Intents), que eram basicamente formas de os desenvolvedores deixarem algumas partes dos seus apps acessíveis à Siri. Na prática, esse sistema representava uma forma bastante rudimentar (e trabalhosa) de dar à Siri a função de um agente, só que sem nada de IA. O desenvolvedor declarava ao sistema que seu app tinha, por exemplo, a capacidade de chamar um carro a partir da localização do usuário, programava quais ações a Siri poderia executar e, na melhor das hipóteses, torcia para dar certo.

Complicado? Pois é. Justamente por isso, a funcionalidade não decolou. Com MLLMs e agentes, essa lógica poderá se inverter. Imagine a seguinte situação: o usuário está em um jantar e quer chamar um carro por aplicativo para ir para casa. Quando a cidade oferece mais de um app, não é incomum a pessoa abrir todos esses apps, comparar os preços, os prazos de chegada, e tomar a decisão.

Com a capacidade que o Ferret-UI oferece à Siri para compreender o que está na tela (mesmo sem nunca ter visto aquela tela antes) e, munida das habilidades de um agente, a Siri poderia proativamente, por exemplo, navegar pelas interfaces por conta própria e de forma simultânea, decidir em nome do usuário qual é a melhor opção (com base em análise de comportamentos e de trajetos passados, por exemplo), e apenas lhe informar o horário de chegada e a placa do veículo. Tudo isso sem exigir trabalho extra por parte dos desenvolvedores e sem parar de funcionar, caso o app mudasse a interface.

Agora imagine, por exemplo, poder aplicar essa mesma lógica para a contratação de serviços (“O chuveiro está vazando, chame alguém para resolver ainda hoje”), compra de produtos (“Fique de olho no preço do café nos mercados que eu acesso e compre 500g se um deles baixar ao longo da próxima semana”), ou até mesmo para simplificar coisas como detalhes de viagens (“Estarei no Rio de Janeiro na sexta, reserve um restaurante com um bar legal na região de Botafogo às 20h”).

Ou, de um ponto de vista ainda mais prático, cumprir pedidos como “Responda a esse email com o PDF da ata da reunião de ontem”, “Pesquise sobre isso e salve um resumo e links no app Notas”, ou “Cheque no meu app de timer quanto tempo eu trabalhei no projeto Y entre janeiro e março, salve numa planilha do Numbers e mande pro meu chefe”.

Resumo da ópera

Se você está pensando “Eu nunca vou deixar a Siri gastar meu dinheiro ou tomar decisões por mim sem que eu veja antes o que ela está fazendo”, você definitivamente não está sozinho. Dados os últimos 13 anos frustrantes da assistente da Apple, eu também levarei um certo tempo até confiar que eu poderei pedir à Siri para chamar um carro para eu ir para casa, e ela não comprará uma passagem para eu ir à Malásia.

Por outro lado, é justamente essa a beleza desse momento empolgante que estamos vivendo. Se houve um breve momento em que a Siri parecia ser o futuro, cá estamos vendo esse futuro se manifestar na forma MLLMs e agentes — os quais demonstram tanta promessa que até a Siri eles podem passar a deixar inteligente!

Notas de rodapé

- 1Large language models, ou, grandes modelos de linguagem.

- 2Arriscado? Sem dúvida. Empolgante? Também!

- 3Muitas pessoas criticam o uso de termos que antropomorfizam a IA dessa forma, mas reasoning/raciocínio é um termo amplamente compreendido e aplicado em discussões técnicas e acadêmicas no campo da IA.