A Apple divulgou recentemente um novo estudo detalhando o MLLM 1Multimodal large language model, ou grande modelo de linguagem multimodal. Ferret-UI, uma espécie de evolução do modelo lançado no ano passado para entender interfaces de usuário usando inteligência artificial. Segundo o paper, esse modelo seria mais eficiente que o GPT-4V e outros focados em UI.

O Ferret-UI tenta solucionar um problema com os grandes modelos em analisar interfaces de dispositivos móveis: a grande quantidade de elementos distintos e em tamanhos pequenos presentes. Além disso, as capturas de tela costumam ter proporções mais alongadas que as de imagens tradicionais, bem como diferentes disposições (horizontal ou retrato).

Esses problemas foram solucionados com a aplicação de uma técnica denominada “any resolution” (ou “qualquer resolução”) ao Ferret. Essa técnica é usada para adaptar o modelo às diferentes proporções e aspectos de telas móveis, bem como para facilitar o entendimento de elementos menores (como ícones, botões e textos).

A imagem é dividida em subimagens (na horizontal para imagens em modo retrato e na vertical para modo paisagem), as quais são codificadas separadamente antes de serem enviadas ao modelo de linguagem — permitindo tanto uma análise mais específica quanto uma global da interface móvel em questão.

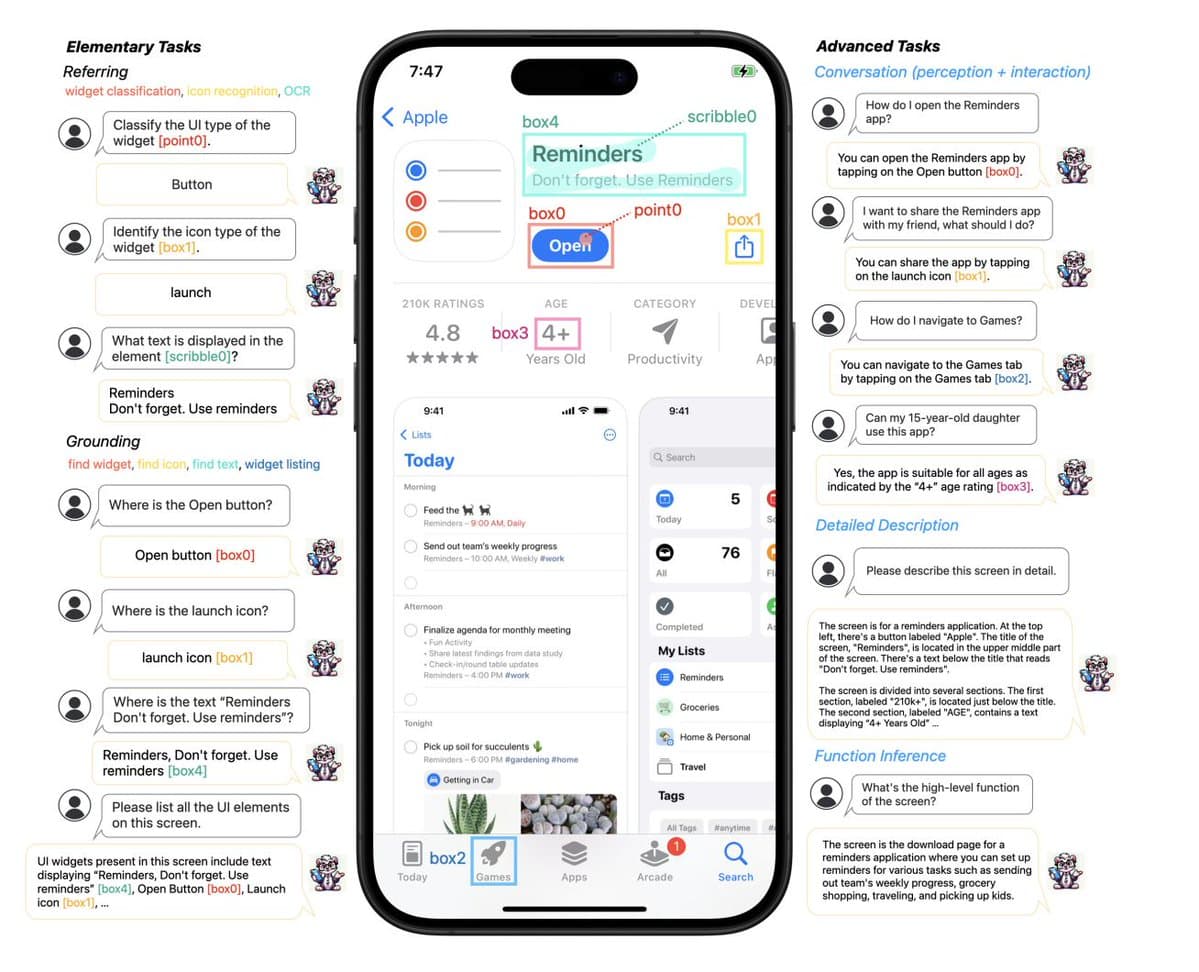

Entre as características do Ferret-UI, estão capacidades básicas como as de referenciar e fundamentar diferentes categorias de elementos (como widgets e ícones), bem como realizar tarefas mais avançadas, como fazer uma descrição detalhada da interface, entender conversas ou realizar inferência de função.

Embora o artigo não explicite possíveis aplicações para o Ferret-UI, o 9to5Mac elencou algumas bem interessantes, como ajudar desenvolvedores a avaliar a eficiência de interfaces ou até mesmo fornecer um resumo do conteúdo presente na tela para pessoas com deficiência (como uma alternativa aos leitores tradicionais).

Outra possível aplicação seria para ampliar as possibilidade envolvendo a Siri, que teria a capacidade de entender detalhadamente o que está acontecendo na interface e, quem sabe, até mesmo interagir com os elementos presentes nela a pedido dos usuários.

Notas de rodapé

- 1Multimodal large language model, ou grande modelo de linguagem multimodal.